Aunque las herramientas estandarizadas pueden captar resultados observables, suelen pasar por alto factores internos, como la motivación, la percepción y la indecisión, que determinan la toma de decisiones reales en el ámbito del desarrollo. En un proyecto con pequeños agricultores en China, las respuestas de las encuestas proporcionaron poca información sobre estos procesos, poniendo de relieve la necesidad de enfoques basados en el comportamiento que revelen dimensiones infravaloradas de los cambios.

Aunque las herramientas estandarizadas pueden captar resultados observables, suelen pasar por alto factores internos, como la motivación, la percepción y la indecisión, que determinan la toma de decisiones reales en el ámbito del desarrollo. En un proyecto con pequeños agricultores en China, las respuestas de las encuestas proporcionaron poca información sobre estos procesos, poniendo de relieve la necesidad de enfoques basados en el comportamiento que revelen dimensiones infravaloradas de los cambios.

Herramientas del comportamiento en la evaluación: de lo marginal a lo convencional

Se está empezando a reconocer esta carencia. La Nota orientativa sobre ciencias del comportamiento del Secretario General de las Naciones Unidas insta a los organismos a “explorar y aplicar las ciencias del comportamiento en las esferas programáticas y administrativas”, y la Semana de las Ciencias del Comportamiento de las Naciones Unidas de 2025 presentó la labor de 46 organismos de Naciones Unidas, con temas que van desde el clima hasta la inclusión digital y la protección social. Estas herramientas han dejado de ser instrumentos especializados: se están institucionalizando.

La Unidad de Integración Mente, Comportamiento y Desarrollo (eMBeD, por sus siglas en inglés) del Banco Mundial incorporó información sobre el comportamiento en las evaluaciones realizadas en más de 70 países. Esto ayudó a los equipos a ir más allá de indicadores superficiales y descubrir cómo las personas toman decisiones con restricciones reales. Por su parte, la herramienta de Autoevaluación y evaluación integral de la resiliencia al cambio climático de agricultores y pastores (SHARP+, por sus siglas en inglés) de la Organización de las Naciones Unidas para la Alimentación y la Agricultura (FAO) adaptó encuestas de hogares incorporando preguntas sobre el comportamiento de los agricultores, a fin de comprender por qué adoptaban o rechazaban determinadas prácticas agrícolas. En lugar de quedarse en las tasas de aceptación de dichas prácticas, la evaluación exploró las percepciones, compensaciones recíprocas y modelos mentales que impulsaban las elecciones de los agricultores. Estos cambios reflejan un reconocimiento más amplio: no podemos comprender el impacto si no comprendemos el comportamiento.

Cuando las herramientas habituales no son suficientes

A pesar de este impulso, las herramientas tradicionales de evaluación del comportamiento —en especial las encuestas estandarizadas— suelen tener dificultades para captar cómo piensan y se comportan las personas. No se trata únicamente de que las preguntas no estén bien redactadas, sino que refleja un desajuste estructural entre unos instrumentos rígidos y la complejidad del mundo real.

Muchas preguntas de las evaluaciones sobre el comportamiento o la actitud tienen su origen en poblaciones occidentales, educadas, industrializadas, ricas y democráticas (WEIRD, por sus siglas en inglés) y están destinadas a ellas. Presuponen que los encuestados están familiarizados con conceptos abstractos, la lógica individualista y los marcos formales de adopción de decisiones. Sin embargo, estas hipótesis no se suelen ajustar a la realidad en los contextos de la mayoría de programas de desarrollo. Por ejemplo, en entornos rurales, conceptos como la “capacidad de acción individual” o la “preferencia de riesgo” quizás no se traduzcan de forma útil al idioma local o a la vida cotidiana. A los encuestados les puede costar interpretar preguntas abstractas o formatos de la escala Likert. No por falta de capacidad, sino porque el marco conceptual es culturalmente distante y cognitivamente ajeno.

Esta carencia en materia de comprensión se ve agravada por el sesgo de conveniencia social. En comunidades muy unidas, donde el estatus, el prestigio o el respeto a la autoridad son muy importantes, sus miembros tienden a adaptar sus respuestas para que se ajusten a lo que creen que se espera de ellos. Como consecuencia, las respuestas pueden reflejar normas sociales, más que creencias o intenciones reales, ocultando precisamente los comportamientos que las evaluaciones pretenden conocer.

La medición del comportamiento reinventada como un juego

En mi propio trabajo, estas limitaciones no eran teóricas, sino realidades sobre el terreno. Nos propusimos medir las preferencias de riesgo entre los pequeños agricultores de Shanxi y los pastores nómadas del interior de Mongolia. La preferencia de riesgo es un factor fundamental en el desarrollo rural: influye en si los agricultores adoptan nuevas tecnologías, invierten en insumos, diversifican sus ingresos o participan en sistemas formales de seguros y crédito. Sin embargo, las encuestas con escala de Likert resultaron inadecuadas. Los encuestados tuvieron dificultades para comprender el lenguaje abstracto y sus respuestas solían ser cautelosas o incoherentes, probablemente debido a malentendidos o a expectativas sociales.

Así que creé algo diferente: un juego de comportamiento basado en WeChat. Utiliza el globo analógico de tareas de riesgo (BART), un experimento consolidado que mide la asunción de riesgos de forma lúdica. En este sencillo experimento, los jugadores inflan un globo virtual para ganar recompensas, arriesgándose a que este explote cada vez que lo hinchan. El juego no pregunta por el riesgo: lo revela por medio del comportamiento ante la incertidumbre.

Integrada en un miniprograma de WeChat, esta herramienta pasó a estar disponible en cualquier teléfono con conexión a Internet, sin necesidad de descargas ni conocimientos técnicos. Un diseñador de experiencia de usuario ayudó a simplificar la interfaz para personas mayores y con un nivel bajo de alfabetización (Figura 1), y un desarrollador se encargó de la recopilación de datos en segundo plano y el seguimiento en tiempo real. Los encuestadores podían guiar a los participantes a través del juego en cuestión de minutos (Figura 2).

Figura 1. Recursos visuales para el juego para móviles utilizado en la evaluación.

Estos módulos de globos de colores proporcionaban información visual relacionada con el comportamiento de riesgo de los participantes

Figura 2. Interfaz del juego. Los jugadores pulsan el botón verde para inflar el globo u obtener su recompensa.

Por qué las tareas de comportamiento funcionaron mejor que las encuestas

- No requieren razonamiento abstracto: los participantes se limitan a jugar.

- Las respuestas tienen poco sesgo: no es necesario autoevaluarse ni justificar las elecciones.

- Hay menos obstáculos: aplicación familiar, diseño intuitivo.

- Se obtienen datos de comportamiento directos: decisiones observadas en situaciones reales.

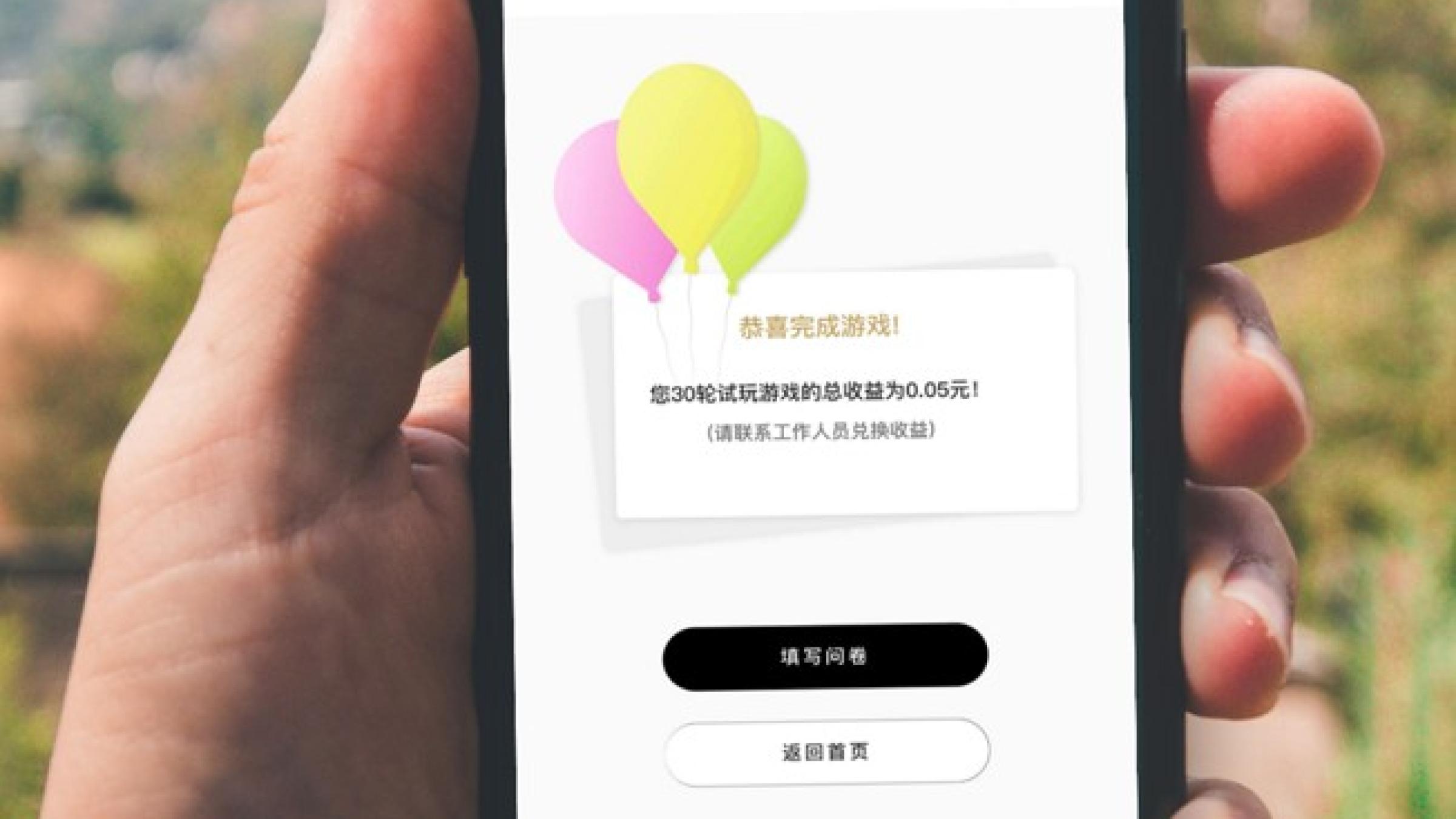

A los encuestados el juego les resultó interesante. Algunos incluso pidieron volver a jugar (Figura 3). Más que una herramienta de datos, el juego abrió un espacio para el diálogo, haciendo que la evaluación se percibiera como un ejercicio menos extractivo y más colaborativo. Los datos mostraron cómo las herramientas de comportamiento pueden transformar la propia experiencia de evaluación cuando se diseñan de forma conjunta y se integran a nivel local.

Figura 3. Pantalla de resultados del juego en el teléfono de un encuestado. Muestra la recompensa final por la tarea.

La inteligencia artificial como facilitadora de herramientas de evaluación rápidas y de bajo coste

Todo lo anterior fue posible gracias a un nuevo enfoque, pero también debido a una tecnología accesible. Para crear estas herramientas era preciso contar con un equipo técnico completo. Hoy en día, la inteligencia artificial (IA) facilita la creación de prototipos de mediciones de comportamiento con unos conocimientos mínimos de programación. Un ejemplo clave es el vibe coding (programación intuitiva),[1] un flujo de trabajo en el que los usuarios describen lo que quieren utilizando un lenguaje sencillo y la IA ayuda a generar el código subyacente. Por ejemplo, un evaluador puede pedir lo siguiente: “Crear una tarea en la que los usuarios asignen tokens entre una cuenta personal y una cuenta compartida para medir la toma de decisiones cooperativa”. La IA puede devolver una secuencia de comandos en Python, que el evaluador puede probar, adaptar y perfeccionar. Plataformas como Hugging Face (p. ej. con herramientas como Gradio o Streamlit) pueden convertir ese código en aplicaciones web interactivas, mientras que Figma hace que personas sin conocimientos de programación puedan crear maquetas visuales de interfaces de usuario para tareas y evaluaciones. En conjunto, estas herramientas permiten pasar de un concepto a un prototipo de forma rápida y a bajo coste, incluso sin un equipo dedicado a la programación o el diseño. Aunque aún son necesarios algunos conocimientos técnicos, las tareas que antes requerían múltiples expertos pueden ser realizadas ahora por una sola persona con conocimientos básicos, reduciendo el tiempo, el coste y la complejidad.

Repensar el comportamiento, reescribir la evaluación

Si queremos conocer el comportamiento en el ámbito del desarrollo, necesitamos herramientas que lo reflejen. Las encuestas estandarizadas basadas en hipótesis no lo lograrán. Para que la evaluación sea más inclusiva, creíble y preparada para el futuro, necesitamos métodos que se basen en la forma en que las personas toman realmente las decisiones en el ámbito del desarrollo.

Desde un juego para móviles en la China rural hasta los diagnósticos de comportamiento de las Naciones Unidas y el Banco Mundial, es evidente que la evaluación está evolucionando. El siguiente paso es ampliar de forma creativa nuestro conjunto de herramientas: explorar las mediciones de comportamiento en entornos reales, utilizar la IA para facilitar el diseño de herramientas y abrir espacios para la creación conjunta con aquellas comunidades que pretendemos comprender.

[1] Vibe coding es un concepto emergente que hace referencia al uso de IA para traducir instrucciones en lenguaje cotidiano a código fuente. Permite a personas sin conocimientos técnicos generar y adaptar secuencias de comandos a través de plataformas como OpenAI (ChatGPT + intérprete de código), Hugging Face Spaces o aplicaciones Streamlit.